这个问题源于我对如何确定逻辑模型是否足够好的实际困惑。我有模型在它们形成为因变量两年后使用对个体项目的状态。结果是成功(1)或不成功(0)。我在配对形成时测量了自变量。我的目标是测试我假设会影响配对成功的变量是否会影响该成功,同时控制其他潜在影响。在模型中,感兴趣的变量是显着的。

使用 中的glm()函数估计模型R。为了评估模型的质量,我做了一些事情:默认情况下glm()为您提供residual deviance、 theAIC和 the BIC。此外,我计算了模型的错误率并绘制了分箱残差。

- 与我估计的其他模型(并且嵌套在完整模型中)相比,完整模型的残差、AIC 和 BIC 更小,这让我认为这个模型比其他模型“更好”。

- 该模型的错误率相当低,恕我直言(如Gelman 和 Hill,2007 年,第 99 页):

error.rate <- mean((predicted>0.5 & y==0) | (predicted<0.5 & y==1)约为 20%。

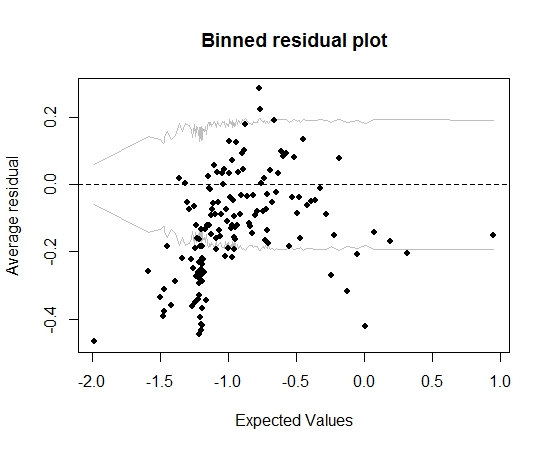

到现在为止还挺好。但是当我绘制分箱残差时(再次遵循 Gelman 和 Hill 的建议),很大一部分分箱落在 95% CI 之外:

那个情节让我认为这个模型有一些完全错误的地方。这会导致我把模型扔掉吗?我是否应该承认模型不完美但保留它并解释感兴趣变量的影响?我已经玩弄了依次排除变量以及一些转换,但没有真正改善分箱残差图。

编辑:

- 目前,该模型有十几个预测变量和 5 个交互效应。

- 这些对是“相对”相互独立的,因为它们都是在很短的时间内形成的(但严格来说,不是同时发生的),并且有很多项目(13k)和很多个人(19k) ),所以相当比例的项目只有一个人加入(大约有 20000 对)。