我正在构建一个 TensorFlow 卷积神经网络,但它没有达到我希望的准确度。所以我想我会可视化学习到的权重,看看网络可能在哪里绊倒。作为基准,我开始可视化一个完全不同的项目的权重,谷歌的 MNIST convnet 示例,它具有非常高的准确度 (99.2%)。

我假设一个非常准确的模型会有直观的权重,但实际上我得到的权重看起来完全随机。其他人似乎得到了类似的随机结果。请参阅 martin-gorner 在 3 月 18 日对视觉效果的评论。他的结果与我的相似。

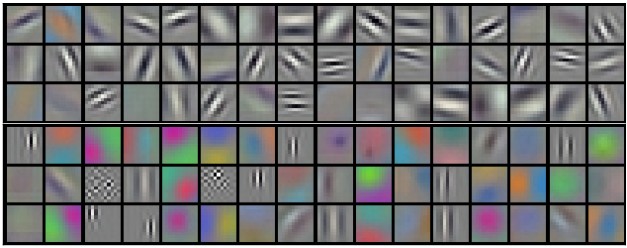

更多谷歌搜索表明,其他人看到非 MNIST 数据集的基本随机行为。这很常见吗?如果是这样,那么将权重可视化似乎是一项徒劳的练习,不太可能为建模者带来任何有用的见解。这是真的?如果不是,为什么这么多人在描述卷积网络的工作原理时使用这种视觉效果(第一层边缘清晰,后续层合成图像)?在可视化权重时,斯坦福的课程材料似乎也至少显示了边缘(您必须向下滚动大约一半的页面)。我不知道该怎么想。